新像素4a支持Live HDR +和双曝光,首先用像素4引入的功能(请注意,这些不适用于旧设备)。Tech Giant发布了详细的博客文章,了解两个功能如何工作。

首先,什么是现场HDR +?它显示了最终HDR +照片的实时预览。请注意,这只是使用不同算法导出的预览。真正的HDR +需要3-15个曝光不足照片(减少噪音),对齐它们并合并它们。

合并后,应用音调映射以产生最终的照片,其中突出显示和阴影中的细节是可见的。手机计算2D直方图以实现这一目标,这是有趣的。

但是,当前的移动芯片组没有计算能力每秒执行30次。相反,使用了一个AI的冲短。将图像切成小块,并且AI预测每个映射。然后,取景器上的每个像素被计算为来自最近的图块的音调映射的组合。

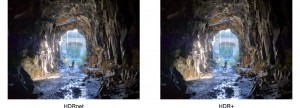

这是预测图像与实际HDR +结果之间的比较。它并不完全正确,但它看起来非常接近(特别是因为你“LL在手机上看到这一点)。

预测的HDR图像(在取景器中看到)与实际HDR +结果

预测的HDR图像(在取景器中看到)与实际HDR +结果

平衡亮点和阴影由HDR +自动完成。双曝光滑块可让您对过程进行手动控制,因此您可以在相机中获得所需的照片。传统上,这是您通过处理原始文件之后的事情。

相同的场景,对双曝光滑块的不同调整

相同的场景,对双曝光滑块的不同调整

如果您想要更详细的解释所有这些工作,您可以遵循Google的博客文章的源链接。