谷歌的像素4和4 XL标记首次谷歌在智能手机中使用双主摄像机,跨两个像素和Nexus阵容。在最新的谷歌AI博客文章中,Google解释了它在双摄像机上改进了深度感测,以及如何改善距离感知,需要知道需要模糊的东西。

除了仅使用第二个摄像头,谷歌还使用第二个相机的自动对焦系统来提高深度估计,以与单反相机的自然散景的外观更紧密地匹配。

利用像素2和像素3,Google将每个像素分开从单个相机进行比较两个略微不同的图像并尝试计算深度。这种图像的略微差异称为视差,对于收藏率非常有效,但更难以进一步困难。

通过第二次摄像头,Google可以抓住更激烈的视差。既然,这两个图像来自两个不同的相机,大约约13mm的相机,深度变得更加明显,并且可以更准确地估计整体图像的深度。

资源:谷歌

资源:谷歌左侧的照片显示了像素2和3的单凸轮设置上使用的半像素差,而右侧的图像显示两个相机之间的图像差异。它不会阻止那里;虽然第二次摄像机抓取有关场景的水平信息,但是来自每个摄像机的半像素信息看到了不太剧烈,但仍然有用,垂直变化。

资源:谷歌

资源:谷歌这使得相机看到四通视差,从而使相机更有用的信息,其符合像素2和像素3的双像素方法。这帮助谷歌的相机在像素4上,以减少深度误差(坏散孔线)并估计进一步的物体的距离。

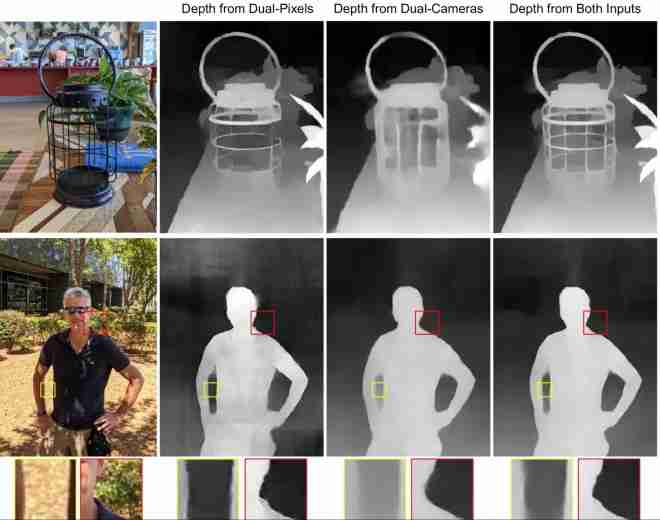

此图像解释了双像素和双摄像机信息如何用于创建图像的整体深度图。像素4还可以在来自其他相机的情况下不可用的情况下适应。一个示例谷歌给出了,如果“这个主题太关心了辅助远摄相机专注于”。在这种情况下,相机将仅使用用于图像的双像素或双相机信息。

资源:谷歌

资源:谷歌最后,通过散焦,散焦涂覆散孔,这导致合成的“磁盘”,其较大远离它们是它们。在图像模糊后,Tonal映射就会发生,但谷歌曾经以另一种方式做到这一点。模糊导致图像失去细节和闪烁的闪烁在一起,但是当完成当前方式(首先模糊,那么音调映射)时,将保持像素的对比外观。

资源:谷歌

资源:谷歌尽管推出了像素4的Lukewarm评论,但由于谷歌的工程师已经进入图像处理和HDR +,它具有现象相机。所以下次你在像素2甚至像素3A上短暂地等待HDR +来处理新拍摄的肖像,请记住,在工作中的一些谷歌魔法值得简而言之。